地图

matlab

python入门

缓存

功能测试

EPICS

亚马逊

测试开发

蔚来

服务监控

卷积神经网络

网站安全防护

openresty

同步锁

EEG

高精地图

智能路由器

校园二手交易系统

C++11

金仓数据库

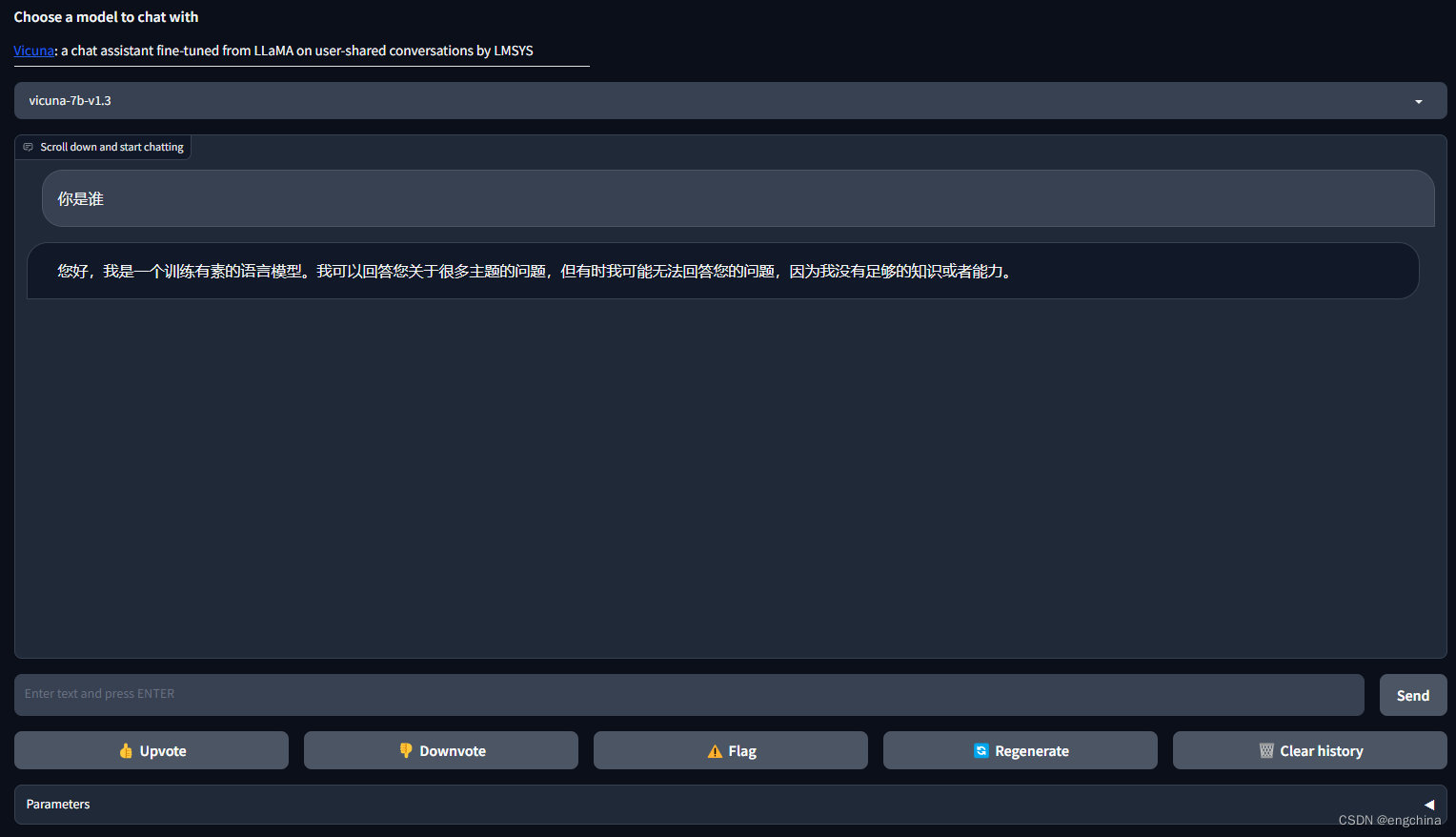

FastChat

2024/4/24 19:37:16本地部署 FastChat

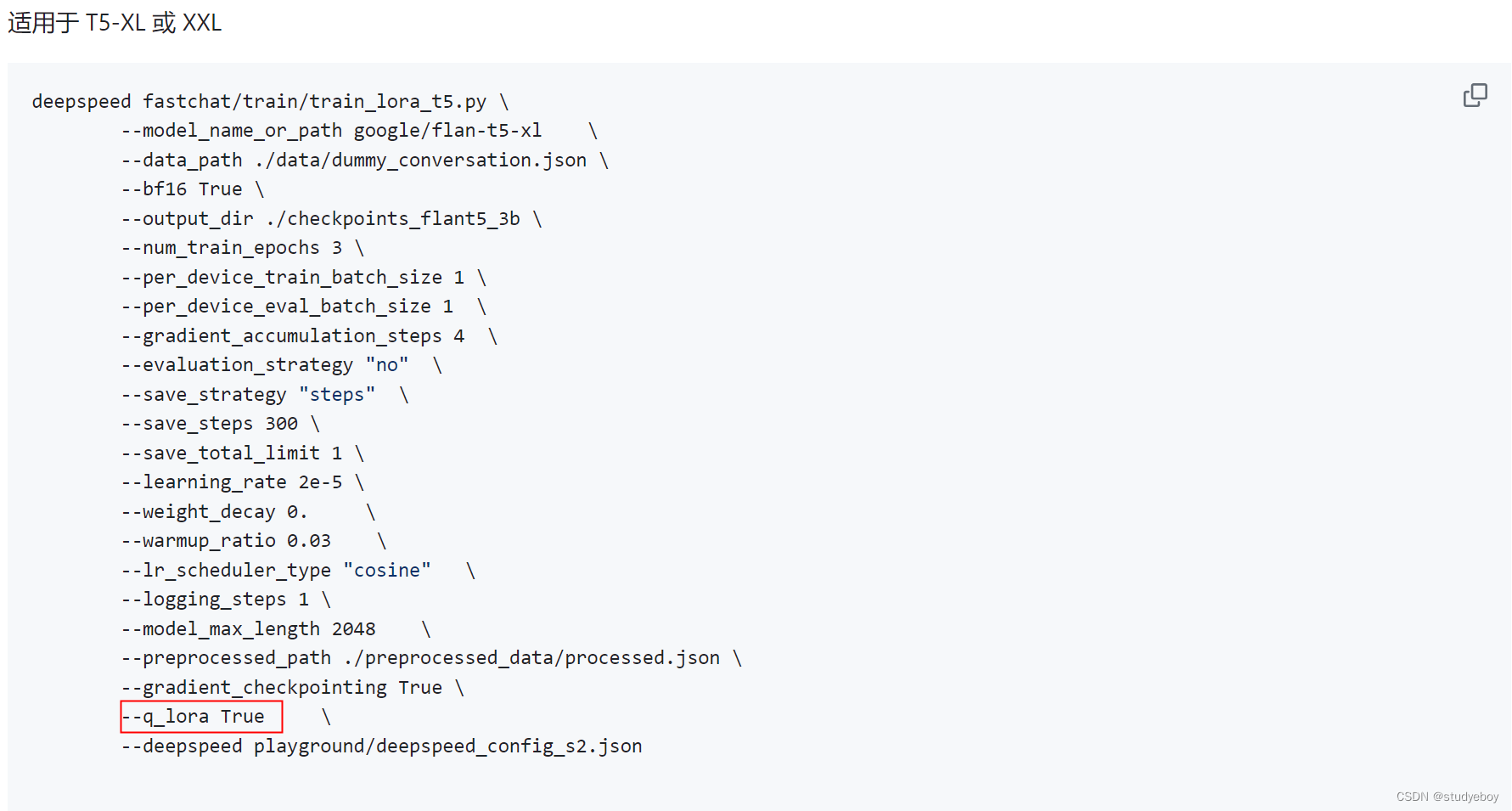

本地部署 FastChat 1. 什么是 FastChat2. Github 地址3. 安装 Miniconda34. 创建虚拟环境5. 安装 FastChat6. 使用命令行进行推理7. 使用 Web GUI 服务进行推理8. 使用 Lora 进行训练9. 其他 文章还在创作中。。。

1. 什么是 FastChat

FastChat 是一个开放平台,用…

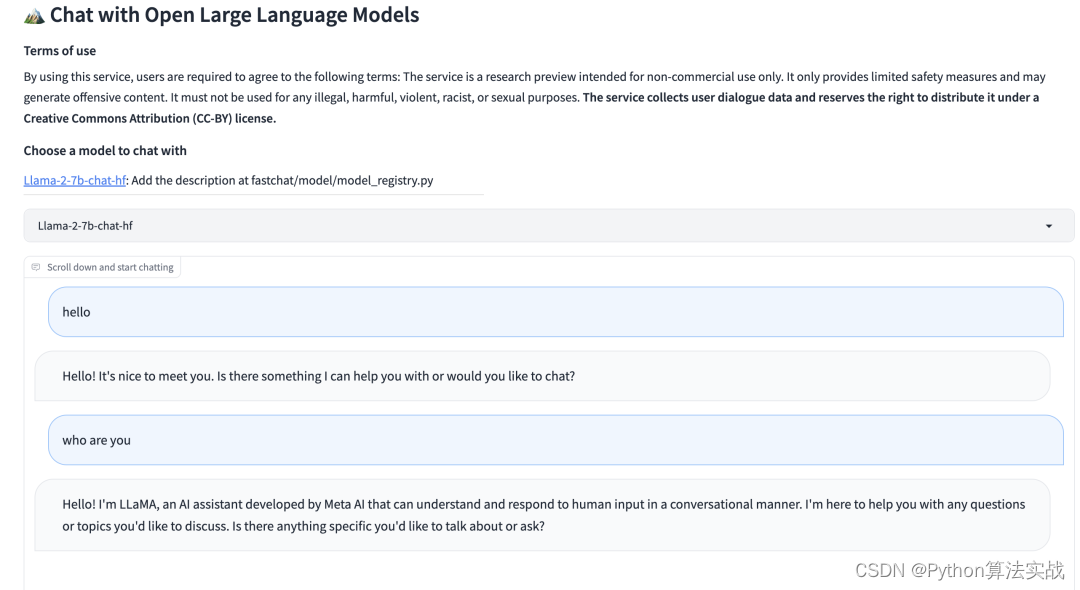

Fastchat:基于fastapi构建大模型加载服务

Fastchat:基于fastapi构建大模型加载服务 Fastapi LLM支持FastChat 服务架构安装方法一:pip方法二:源文件 加载大模型推理1.命令行2.Web启动控制器启动模型工作启动 Gradio Web 服务器注册多个模型 3.兼容 OpenAI 的 RESTful API RESTful API…

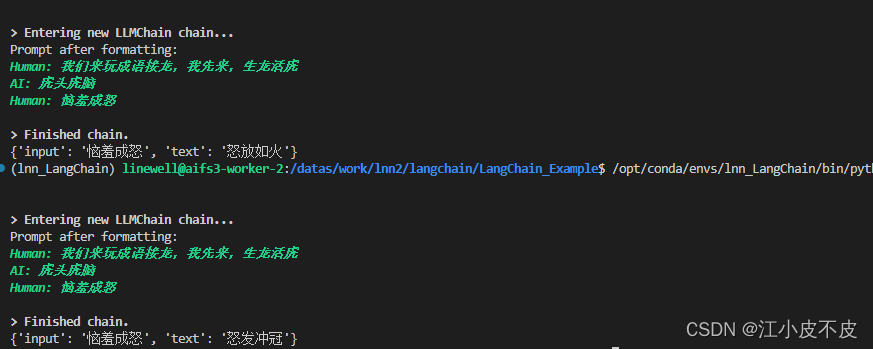

用通俗易懂的方式讲解大模型:使用 FastChat 部署 LLM 的体验太爽了

之前介绍了Langchain-Chatchat 项目的部署,该项目底层改用了 FastChat 来提供 LLM(大语言模型)的 API 服务。

出于好奇又研究了一下 FastChat,发现它的功能很强大,可以用来部署市面上大部分的 LLM 模型,可以将 LLM 部署为带有标准…

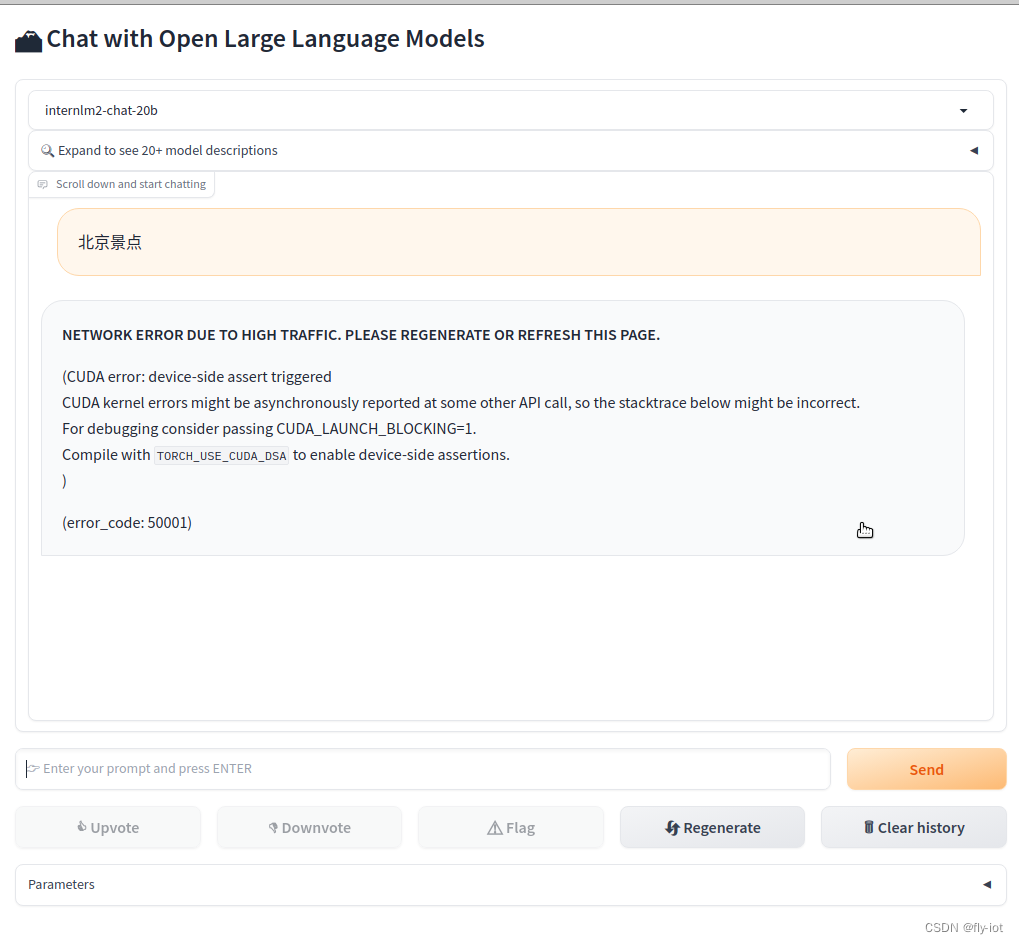

【大模型研究】(1):从零开始部署书生·浦语2-20B大模型,使用fastchat和webui部署测试,autodl申请2张显卡,占用显存40G可以运行

1,演示视频

https://www.bilibili.com/video/BV1pT4y1h7Af/ 【大模型研究】(1):从零开始部署书生浦语2-20B大模型,使用fastchat和webui部署测试,autodl申请2张显卡,占用显存40G可以运行 2&…